英伟达发布新一代自动驾驶芯片Orin、深度学习推理引擎TensorRT 7,GPU已卖15亿块

今年的英伟达GTC,黄仁勋都说了啥?

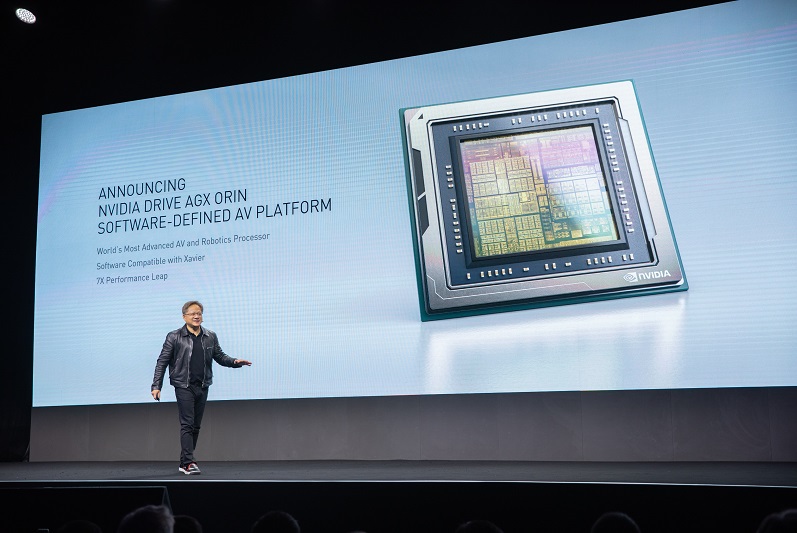

今天,英伟达GTC大会在苏州召开,黄仁勋再次一身皮衣亮相,口头禅从去年的买买买,变为“The more you buy,The more you save”,两个多小时的主题演讲中,“推销”了从云端到边缘各个不同场景下的软硬件产品。

现场,黄仁勋系统地介绍了各个软件平台的新进展,并发布了面向自动驾驶的新一代处理器Orin,以及“实现最大飞跃”的深度学习编译器TensorRT 7。

从云到边缘,英伟达的新重点

从AlexNet到BERT,计算机实现从图像到自然语言处理上的突破。而AI也正在从云端扩展到边缘计算端。

从云到边缘,英伟达正在为了每个场景打造一个平台,包括用于训练的DGX,用于超大规模云的HGX,用于边缘的EGX,以及用于终端的AGX。

以面向终端的AGX为例,自动驾驶和机器人是英伟达的两个重点。

· 自动驾驶:发布DRIVE AGX Orin

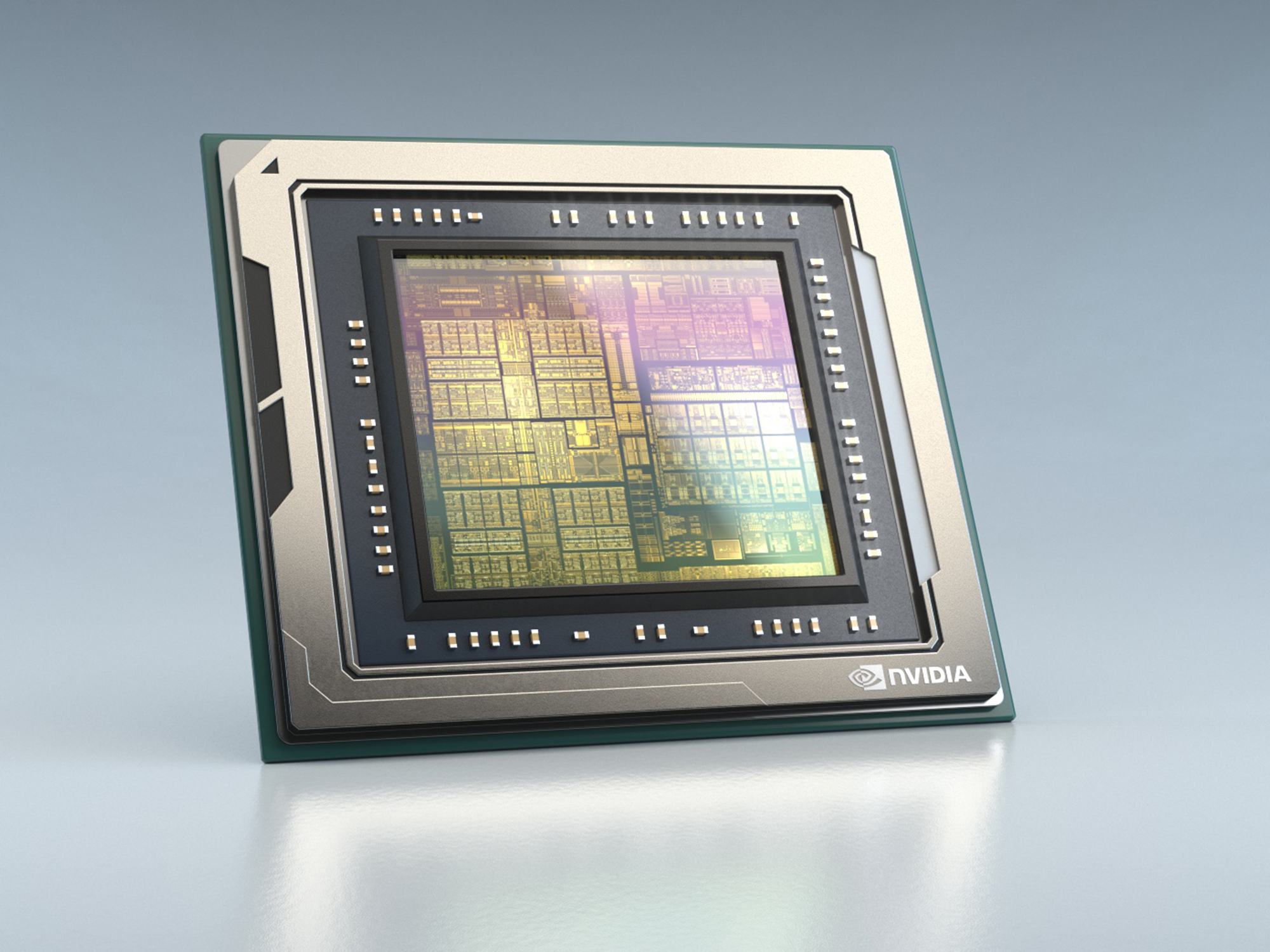

现场,英伟达发布了用于自动驾驶和机器人的软件定义平台——NVIDIA DRIVE AGX Orin。该平台内置全新Orin系统级芯片,Orin由170亿个晶体管组成,集成了NVIDIA新一代GPU架构和Arm Hercules CPU内核以及全新深度学习和计算机视觉加速器,每秒可运行200万亿次计算,是上一代Xavier系统级芯片性能的7倍。

Orin可处理在自动驾驶汽车和机器人中同时运行的大量应用和深度神经网络,并且达到了ISO 26262 ASIL-D等系统安全标准。

值得注意的是,Orin支持可编程,并且有丰富的工具和软件库支持,与之前的Xavier处理器兼容,支持从L2到L5级别的自动驾驶。

而且由于Orin和Xavier均可通过开放的CUDA、TensorRT API及各类库进行编程,因此开发者能够在一次性投资后使用跨多代的产品。

英伟达创始人兼首席执行官黄仁勋表示:“打造安全的自动驾驶汽车,也许是当今社会所面临的最大计算挑战。实现自动驾驶汽车所需的投入呈指数级增长,面对复杂的开发任务,像Orin这样的可扩展、可编程、软件定义的AI平台不可或缺。”

硬件之外,英伟达还发布了一套使用主动学习、联邦学习和迁移学习来训练深度神经网络的工具。以联邦学习为例,可以让多个组织和公司在不移动或共享数据的情况下进行合作,英伟达将训练模型发送给各个合作伙伴,每个合作伙伴在自己的数据上训练模型。

现场,英伟达宣布和滴滴达成合作,滴滴将使用NVIDIA GPU和其他技术开发自动驾驶和云计算解决方案。

· 机器人:发布全新Isaac SDK

今年3月的GTC会议上,英伟达就着重强调了机器人业务。今天,黄仁勋在现场发布了全新版本Isaac软件开发套件(SDK),为机器人提供更新的AI感知和仿真功能。

Isaac SDK包括Isaac Robotics Engine(提供应用程序框架),Isaac GEM(预先构建的深度神经网络模型、算法、库、驱动程序和API),用于室内物流的参考应用程序以及训练机器人Isaac Sim的第一个版本(提供导航功能)。

为了加快AI机器人的开发速度,全新Isaac SDK包括各种基于摄像头的感知深度神经网络,包括:

对象检测——识别用于导航、交互或操控的对象;

自由空间分割——检测和分割外部世界,例如确定人行道在哪里,以及机器人可以在哪里行驶;

3D姿态估计——了解目标的位置和方向,从而实现诸如机械臂拾取物体的任务;

2D人体姿态估计——将姿态估计应用于人,这对于与人互动的机器人(例如配送机器人)和协作机器人(专门设计用于与人合作)非常重要。

以新推出Isaac Sim机器人为例,它可以将所生成的软件部署到在现实世界中运行的真实机器人中。通过仿真,开发人员可以在极端情况下(即困难或异常情况下)对机器人进行测试,以进一步加强对它的训练。这有望大大加快机器人的开发速度,从而实现综合数据的训练。

另外,Isaac SDK还支持多机器人仿真。这使开发人员可以将多个机器人放入仿真环境中进行测试,以便它们学会彼此相关的工作。

发布TensorRT 7,减少会话AI推理延迟

英伟达在去年的GTC China上发布了支持自动低精度推理的TensorRT 5,今天英伟达发布了TensorRT 7,内置新型深度学习编译器,支持各种类型的RNN、CNN和Transformer,相较于TRT 5只支持30种变换,TRT 7可以支持1000多种不同的计算变换和优化。

TRT 7可为开发者设计的大量RNN配置自动生成代码,逐点融合LSTM单元,甚至可跨多个时间步长进行融合,并且尽可能做自动低精度推理。

借助TRT 7,全球各地的开发者都可以实现会话式AI应用,大幅减少推理延迟。举个例子,通常情况下,一套端到端的自然语言理解流程可能由几十种模型构成,比如RNN、CNN、自编码器等等,TRT 7可对所有模型进行编译,使其在英伟达GPU上运行。基于英伟达T4的推理会话AI只需要0.3秒,而CPU的推理延迟却高达3秒。

GPU加CUDA,从火星着陆到基因测序,无所不能

如今,英伟达已经售出了15亿块GPU,在使用的每块GPU都兼容CUDA。英伟达的CUDA平台具有丰富的库、工具和应用程序。仅在去年,英伟达发布了500多个SDK和库,通过优化软件栈,英伟达提高了GPU的性能,让深度学习训练在三年内提高了4倍,深度学习推理在一年内提高了2倍。

HPC应用方面,NASA在英伟达GPU上通过FUN3D软件运行火星着陆情景模拟,产生高达150TB的数据,英伟达借助DGX-2上运行的Magnum IO GPU Direct Storage技术,可“实时”对这些数据进行可视化处理。

另外,由于GPU的训练成本只有传统CPU的十分之一,并且可支持更大规模的模型训练,英伟达发布了深度推荐系统,百度以及阿里均有采用。

CUDA方面,英伟达发布了由CUDA加速的Parabricks基因组分析工具包,可实现30到50倍的加速,目前华大基因已经采用Parabricks来进行基因变异检测,除此之外,CUDA新增加了对5G vRAN应用的支持。

和腾讯合作,推出云游戏服务

在游戏方面,微软出品的游戏《我的世界》支持RTX,可以实时完成预烘焙全局光线和一般反射的灯光效果。同时,黄仁勋还宣布了其他6款GeForce RTX 游戏。

随着谷歌、微软入局云游戏,英伟达也将眼光投向了云游戏,现场英伟达宣布与腾讯合作推出START云游戏服务,由英伟达提供GPU支持。

硬件方面,英伟达为PC笔记本提供的Max-Q设计,可将高性能GPU集成到轻薄笔记本中,数据显示,今年,GeForce RTX MAX 笔记本电脑是增长速度最快的游戏平台。

3D内容创作上,黄仁勋介绍了英伟达的OMNIVERSE的进展,发布面向建筑行业(AEC)的OMNIVERSE,在工作流中增加实时协作功能。

最后:

这一年,英伟达也明显越来越重视边缘以及端侧产品,也一改以往售卖硬件“又贵又大”的规则,推出了性价比超高、便宜好用的小型嵌入式芯片产品。

曾经主导云端AI芯片市场的英伟达,在面对竞争对手的突围后,正在用云端加边缘一体化的解决方案吸引更多客户,并且愈加强调他们在软硬件上的优势。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

云计算

技术

测试

计算机

软硬件

云计算

技术

测试

计算机

软硬件

微信ID:im2maker

微信ID:im2maker

长按识别二维码关注

长按识别二维码关注