目前深度学习存在哪些无法克服的障碍?

关于目前深度学习所面临的障碍,镁客君为大家找来了斯坦福大学在读博士Bharath Ramsundar列出的15个深度学习现在有的问题~

1.众所周知,深度学习方法很难学习到输入样本的微小变化。当样本的颜色交换时,所构建的目标识别系统可能会完全崩溃。

2.基于梯度的网络训练过程相当缓慢。一般按照固定模式来实现多种梯度下降方法,但是这种方法很难用于高维数据的预测。

3.深度学习方法在处理条件约束方面的效果也不佳,不能像线性规划方法那样,能快速找到满足约束的解决方案。

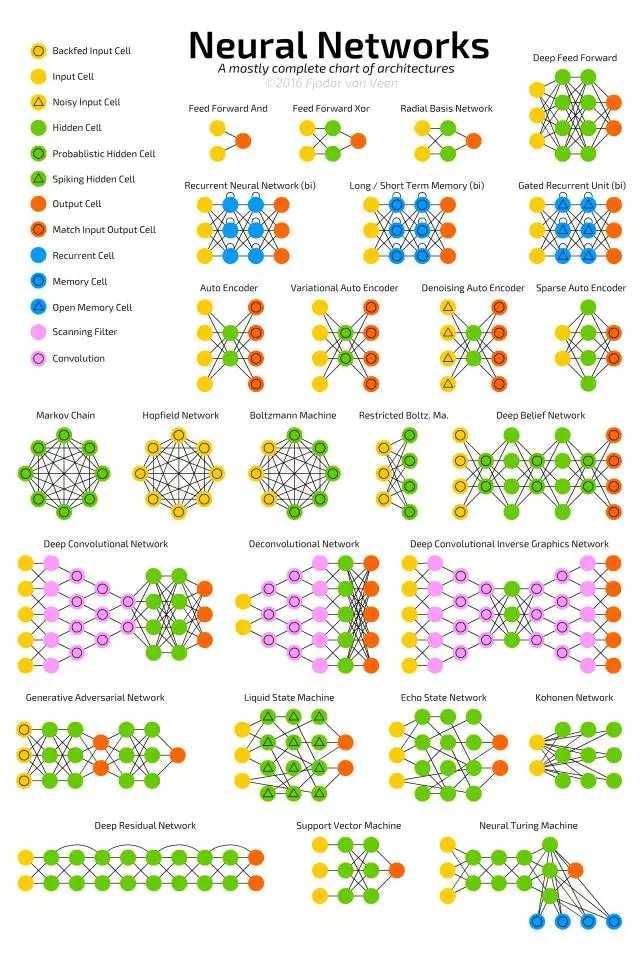

4.在训练复杂模型时,网络相当不稳定。通常不能很好地训练神经图灵机和GAN网络,严重依赖网络的初始化方式。

5.深层网络能较好地应用于图像处理和自然语言分析中,但是不适合现实世界的实际问题,如提取因果结构等等。

6.在实际应用中,要考虑关键影响者检测的问题。在参议员参议员投票的数据集中,应该如何检测出关键影响者,深度神经网络DNN还不能应用于此方面。

7.强化学习(Reinforcement learning)方法对输入数据非常挑剔,实际性能主要取决于调参技巧,虽然这个特殊问题仅存在于这个方面。

8.深度学习方法不容易理解未知实体,比如说当棒球击球手在视频中,深度学习不知道如何推断出屏幕外还有个投手。

9.实时训练深层网络几乎不可能,因此很难进行动态调整,上文已经提到网络训练缓慢的问题。

10.一般来说,网络需通过离线训练后才能进行智能辨识。

11.人们经常提出一些对深层网络的理论解释。但这可能不是一个大问题,人们才是一个真正的大问题。

12.目前很难确定深层网络学习到了什么。作为工程师的我们,怎样才能确保在网络训练过程中不存在偏见和种族歧视?

13.深度神经网络很难用来解决逻辑问题。3SAT求解器具有很强的能力,但是很难应用到深层网络。

14.深度神经网络在处理大维度的特征数据方面效果不佳。这种方法与强大的随机森林方法不同,在训练前需要大量的特征调整。

15.深度网络的超参数优化研究仍然处于起步阶段。研究者需要完成大量的计算或是手动调整许多网络结构。

总结起来是以下几个主要问题:

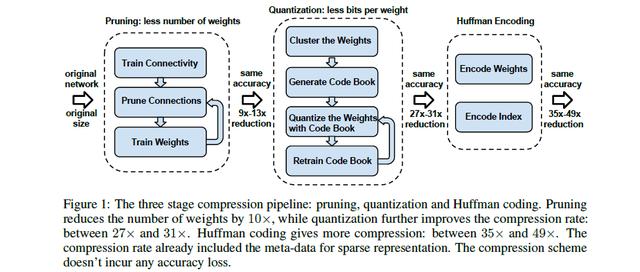

1. 深度网络压缩:目的是将权值参数进行量化或者压缩存储,进而减少参数规模。

2. 模型加速:现在出现了更深的网络,但带来的问题是计算效率的下降。这个方向主要从网络架构和实现的角度对模型的计算效率进行提升。

3. 优化: 现在在ICML上边关于DL优化的文章很多,如何避免overfiting? 如何加速训练?产生初始参数?这些都是比较热门的研究点。

4. 应用:包括检测、分割、人脸、NLP等,一个好的工作会综合考虑各种各样的因素。

5. 迁移:在CV领域work的模型是否可以应用到其他领域?在一个新领域中基本想法有了,但具体做起来需要解决各种各样的实际问题。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

深度学习

深度学习

微信ID:im2maker

微信ID:im2maker

长按识别二维码关注

长按识别二维码关注