谷歌宣布开放Cloud TPU,每小时6.5美元,英伟达还坐得住吗?

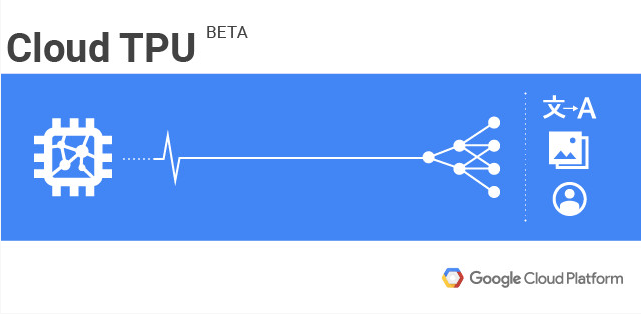

Cloud TPU意图优化计算受限问题,并让机器学习模型训练更加容易。

当地时间凌晨6点多,Google Brain负责人、谷歌首席架构师Jeff Dean连发10条Twitter,只想告诉人们一件事情——我们推出了CloudTPU的beta版,第三方厂商和开发者可以每小时花费6.5美元来使用它,不过数量有限,你需要先行填表申请。

一直以来,TPU都被用于谷歌内部产品,随着Cloud TPU的开放,不管是云服务还是AI芯片市场,都将迎来一场变动。

谷歌开放Cloud TPU测试版,每小时6.5美元,数量有限

在2016年5月,谷歌在I/O大会上首次公布了TPU(张量处理单元)。彼时,TPU已经在谷歌数据中心被使用了一年,而李世石与AlphaGo的那一场世纪大战中,TPU也发挥了效用,并被谷歌成为AlphaGo打败李世石的秘密武器。

而从今天开始,第三方厂商和开发者可以在Google Cloud Platform买到Cloud TPU产品,值得注意的是,此次发放的是测试版,且数量有限。如果你想使用它,就必须先在谷歌申请配额并明确自己的ML需求。

根据Jeff Dean在Twitter发布的第三条推文显示,基于新发布的Cloud TPU,不到一天的时间,人们就可以在ImageNet上把ResNet-50模型训练到75%的精度,成本不足200美元。

Cloud TPU意图优化计算受限问题,并让机器学习模型训练更加容易

谷歌博文显示,Cloud TPU是谷歌设计的硬件加速器,专为加速、扩展特定的TensorFlow机器学习工作负载而优化。每个Cloud TPU由4个定制化的ASIC组成,拥有180万亿次/秒浮点运算的计算能力,以及单块板卡64GB的高宽带内存。

在使用上,这些具备高性能的板卡可以单独使用,也可以通过超高速专用网络形成一个可以达到每秒万万亿次浮点运算的ML超级电脑,谷歌将之称作“TPU pod”。在今年晚些时候,“TPU pod”将在谷歌云上线,通过GCP供应这种更大的超级计算机。

除了解决“机器学习计算受限”这一令很多研究院和工程师都头疼的问题,Cloud TPU还将帮助他们让机器人学习模型训练更加简单易上手。

谷歌表示,利用Cloud TPU加上高水平的TensorFlow API,以及谷歌开源的一些高性能Cloud TPU模型,开发者现在能够迅速展开工作,像是:

ResNet-50 以及其它流行的图片分类模型;

针对机器翻译和语言建模的 Transformer;

针对物体追踪的 RetinaNet;

……

后面,谷歌方面还会开源更多的ML模型。

此外,Cloud TPU还提供了一个可扩展的ML平台,对ML计算资源的计算和管理进行了简化:

为团队提供最先进的ML加速,并根据需求的变化动态调整容量(capacity);

直接使用经过Google多年优化的高度集成机器学习基础设施,无需投入大量金钱、时间、专业人才来设计、安装、维护现场机器学习计算集群,不用考虑供电、冷却、联网、存储要求等问题;

无需安装驱动程序,Cloud TPU全部预配置完成;

享受所有Google云服务同样复杂的安全机制和实践的保护。

一个月之内,谷歌在机器学习连发两个大招

在此之前,谷歌的TPU 一直是在谷歌内部进行使用。目前,TPU已经经历了两代的变革,第一代TPU为谷歌搜索、谷歌翻译、谷歌相册等多种应用提供背后支持。第二代TPU是谷歌于去年Google I/O 大会上推出的“Cloud TPU”,也就是现在面向第三方厂商和开发者开放的产品,

据Jeff Dean表示,第一代TPU主要用于推行运算,而第二代则“加入了能满足训练需求的硬件结构,同时还考虑了如何将这些诶计算单元组合成大型系统的架构方法。”

而在性能方面,根据Jeff Dean今年晒出的“成绩单”,仅第一代TPU,其就比现代GPU或CPU同类产品快15-30倍,性能/功耗约为30-80倍优化。

Cloud TPU此次是首次对外全面开放,而关注谷歌和人工智能的人就会发现,在一个月内,这已经是谷歌第二次出大招了。

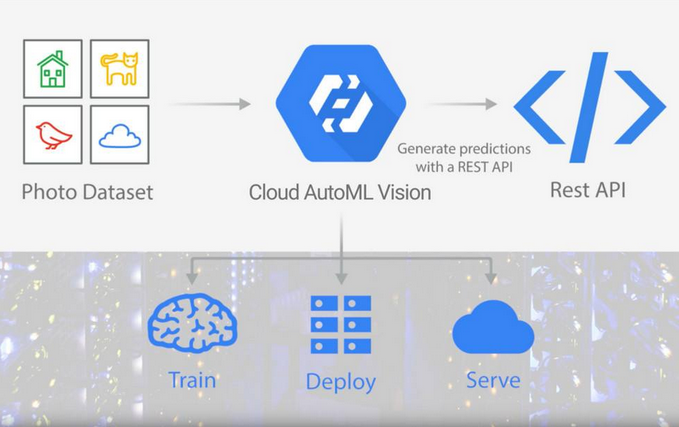

今年1月中旬,谷歌发布Cloud AutoML。简单来讲,谷歌Cloud AutoML就是一个“开发神器”,让不懂机器学习的小白用户也可以训练出一个定制化的机器学习模型——开发者只需要上传一组图片,然后导入标签或者通过App创建,随后谷歌的系统就会自动生成一个定制化的机器学习模型。

当前,鉴于还是Alpha测试版阶段,该服务只支持计算机视觉模型,在后面将陆续支持语音、翻译、自然语言处理等标准机器学习模型。

最后:此前对TPU不以为然的黄仁勋还坐得住吗?

不管是Cloud TPU,还是Cloud AutoML,谷歌所针对的都是机器学习模型的加速以及建模等等。

通过AlphaGo对李世石一战,人们见识到了谷歌TPU的厉害。不过,一直以来,TPU都是谷歌机器学习框架TensorFlow的专用处理器,这也使得AI芯片和云服务的厂商在市场上少了一个“劲敌”。

还记得此前,英伟达的黄仁勋在提及谷歌TPU时,列举了一些参数:新的TPU可以实现45 teraflop的运算能力,而英伟达最新的Volta GPU则能达到120 teraflop。总的来说,就是对其不以为然。

不过,从最新的数据显示,英伟达最新一代Titan显卡Titan V拥有110 万亿次/秒浮点运算的计算能力。相比于Cloud TPU的计算性能,这一款GPU还是有点差距的。

与此同时,鉴于谷歌在云服务市场的占比以及软硬件产品的普及度,在此次开放Cloud TPU后,云服务市场和AI芯片市场必将掀起轩然大波。对此,不知道黄仁勋还坐得住吗?

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

TPU

机器学习

英伟达

谷歌

TPU

机器学习

英伟达

谷歌

微信ID:im2maker

微信ID:im2maker

长按识别二维码关注

长按识别二维码关注