为防止AI乱说话,英伟达推出开源工具包协助大模型

AI还会翻车吗?

随着ChatGPT等生成式AI的爆火,越来越多人享受AI带来的便利。但与此同时,这些AI工具并不是无所不能的,在一些情况下,AI经常会出现“一本正经乱说”的情况,甚至会出现原则性错误。

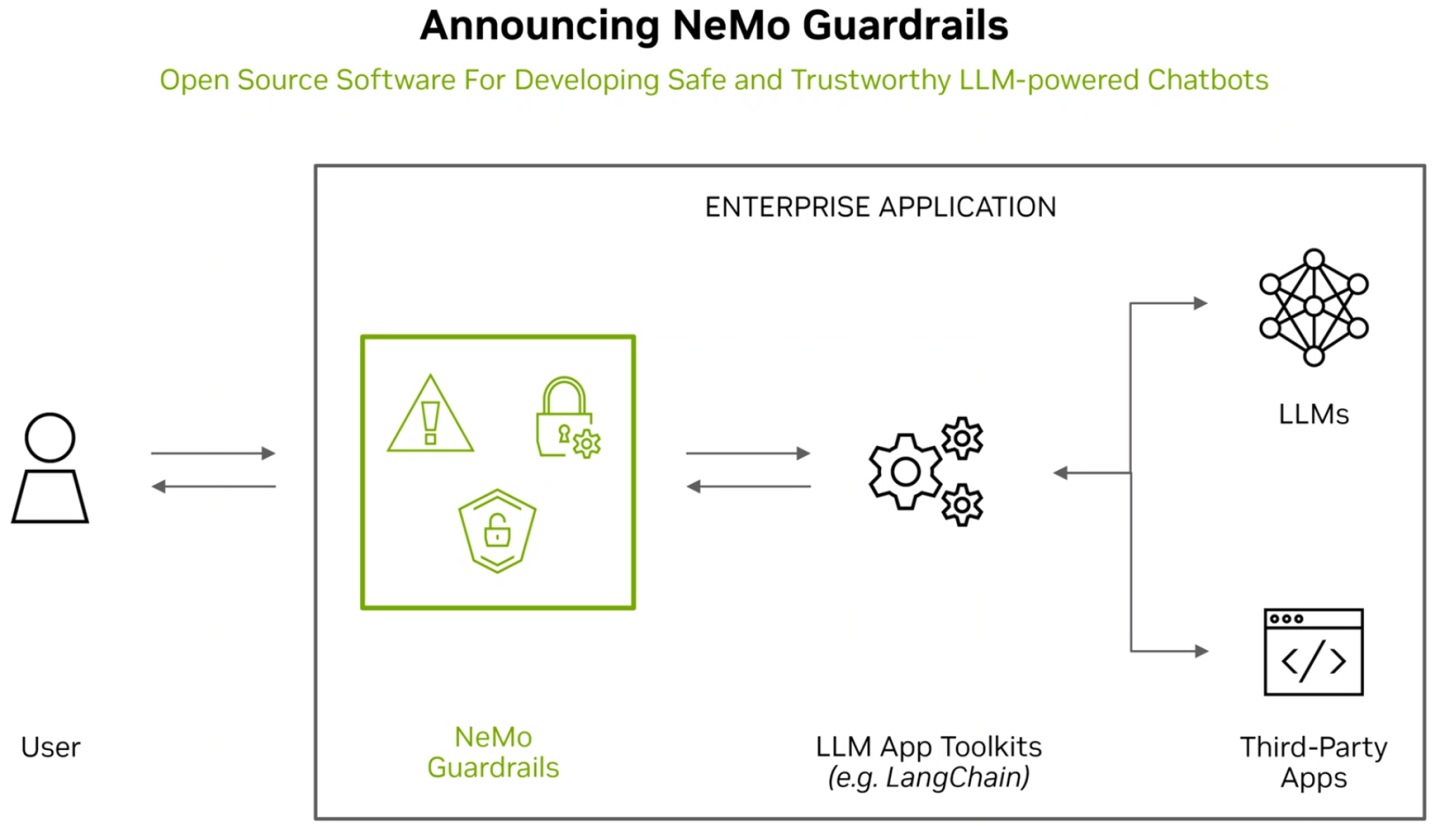

为了让AI工具减少不必要的错误,英伟达在当地时间周二推出了一款名为NeMo Guardrails的开源工具包,它能为人工智能模型设置安全“护栏”,避免AI输出一些不良的内容。

据官方介绍,NeMo Guardrails主要提供三种“护栏”模式,分别是:

1、主题护栏:可以避免应用程序偏离到不想要的领域。

2、安全护栏:确保应用程序回复准确、适当的信息。

3、保全护栏:限制应用程序仅与已知为安全的外部链接建立连接。

简单来说,该软件可以在模型输出不良内容之前进行拦截和修改,从而限制模型的输出范围,并防止模型产生错误或有害的输出。此外,该软件还能够利用一个 AI 模型来检测另一个 AI 模型”,从而提高模型的准确性和可靠性。

英伟达方面表示,受益于开放源代码的特性,NeMo Guardrails可以与企业应用程序开发人员使用的所有工具配合使用,有利于缩端开发时间,整合第三方应用程序与大型语言模型的强大功能,发挥更大的生产力。

换句话说,该工具软件以开源方式推出,可以搭配多种大型语言模型使用。

最后,记得关注微信公众号:镁客网(im2maker),更多干货在等你!

硬科技产业媒体

关注技术驱动创新

AI

人工智能

企业应用

程序

英伟达

AI

人工智能

企业应用

程序

英伟达

微信ID:im2maker

微信ID:im2maker

长按识别二维码关注

长按识别二维码关注